Centro de recursos

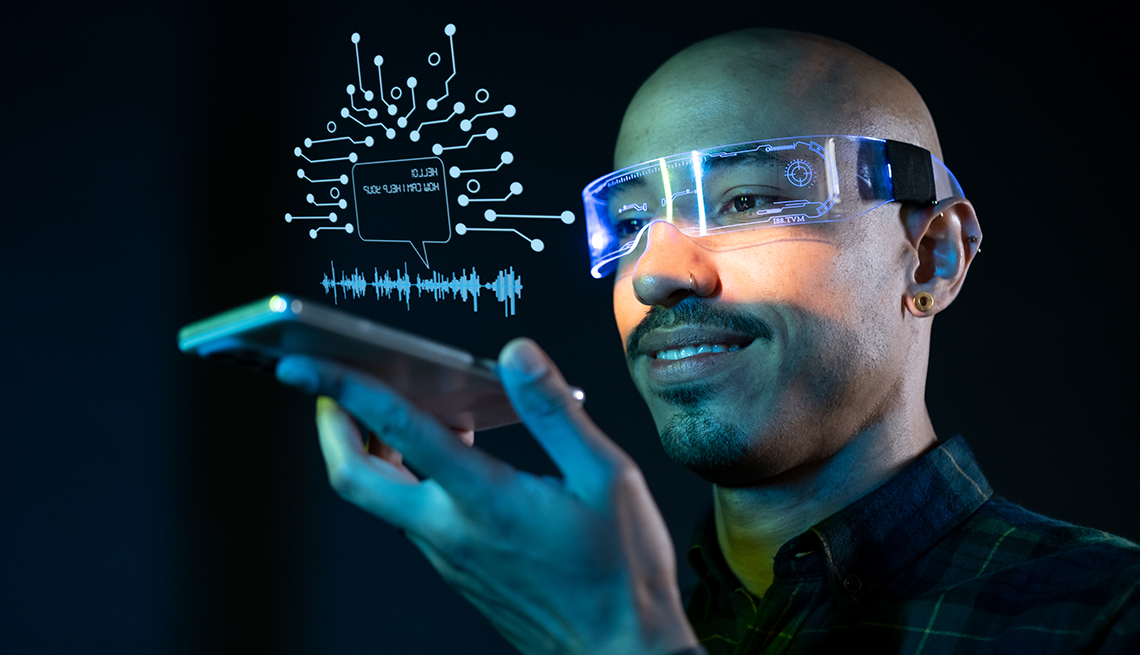

Cuando te despiertas abrumado en mitad de la noche por la pérdida reciente de un ser querido, tu nuevo psicólogo podría ser un chatbot de inteligencia artificial (IA).

Estos chatbots ofrecen consejos y sugieren técnicas para mejorar el estado de ánimo. Y es casi como si estuvieras intercambiando mensajes de texto con un terapeuta humano.

Membresía de AARP: $15 por tu primer año cuando te inscribes en la renovación automática.

Obtén acceso inmediato a productos exclusivos para socios y cientos de descuentos, una segunda membresía gratis y una suscripción a AARP The Magazine.

Únete a AARP

Desahogarte con una aplicación empática que usa inteligencia artificial o un bot de mensajes de texto no es lo mismo que recostarte en un sofá y sincerarte con un psicoterapeuta humano. Ni siquiera se asemeja a llamar a una línea para situaciones de crisis. Pero con las protecciones adecuadas, algunos profesionales de salud mental ven a la IA como una forma de apoyo, al menos para ciertas personas y en determinadas situaciones.

“No creo que [la IA] vaya a reemplazar jamás la terapia o el papel que puede desempeñar un terapeuta”, dice C. Vaile Wright, directora sénior de la Oficina de Innovación en el Cuidado de la Salud de la Asociación Americana de Psicología (APA) en Washington D.C. “Pero pienso que puede satisfacer una necesidad… recordándole a una persona que se siente sola, triste o estresada que aplique técnicas para sobrellevar la situación”.

La inteligencia artificial podría ayudar con la escasez de terapeutas

En el 2021, casi uno de cada cinco adultos buscó ayuda para un problema de salud mental en Estados Unidos, pero más de la cuarta parte de ellos sintieron que no obtuvieron la ayuda que necesitaban, según una encuesta federal anual realizada por la Administración de Servicios de Abuso de Sustancias y Salud Mental (SAMHSA). Aproximadamente el 15% de los adultos de 50 años o más procuraron esos servicios, y uno de cada siete de estos opinó que no recibió la ayuda que necesitaba.

Globalmente, la Organización Mundial de la Salud (OMS) estimó en el 2019 que alrededor del 14.6% de todos los adultos de 20 años o más tenían algún trastorno de salud mental, una proporción prácticamente equivalente a la observada en los adultos de entre 50 y 69 años. Aproximadamente el 13% de los adultos de 70 años o más tenían problemas de salud mental.

La pandemia generó un aumento de los trastornos de depresión y ansiedad; según la OMS, esos trastornos aumentaron más del 25% en todo el mundo. La mayoría de las personas a quienes les han diagnosticado un trastorno de salud mental, incluso antes de que aumentara la necesidad en el 2020, nunca reciben tratamiento. Otras, en cuyos países se ofrecen pocos servicios o donde hay un estigma asociado con el uso de servicios de salud mental, deciden no obtener tratamiento.

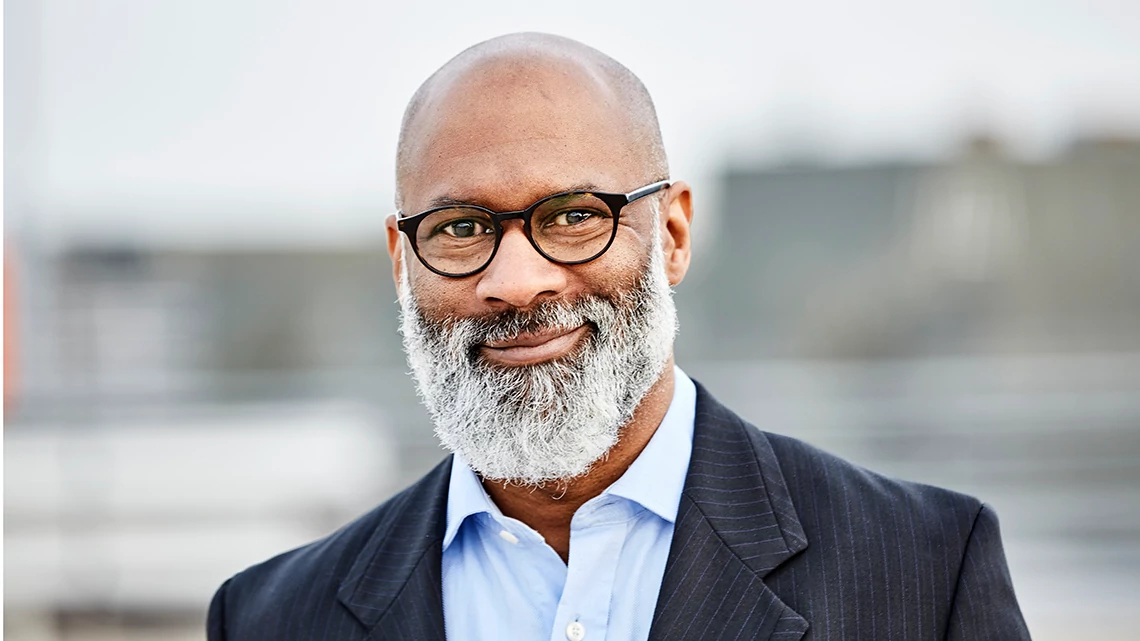

Una encuesta de 3,400 adultos de Estados Unidos realizada en marzo por CVS Health y The Harris Poll en Chicago reveló que el 95% de las personas de 65 años o más opinan que la sociedad debería tomar la salud mental y las enfermedades mentales con más seriedad, dice Taft Parsons III, director psiquiátrico de CVS Health con sede en Woonsocket, Rhode Island. Pero la desaparición del estigma que los adultos mayores de este país a menudo perciben con referencia a la obtención de tratamiento solo causaría un aumento de la necesidad de terapeutas.

“La inteligencia artificial puede aprovecharse para ayudar a los pacientes a superar situaciones estresantes o respaldar la tarea de los médicos de atención primaria en el tratamiento de enfermedades leves, lo cual podría aliviar en algo la presión del sistema de cuidado de la salud”, dice.

ChatGPT no va a reemplazar a Freud... por ahora

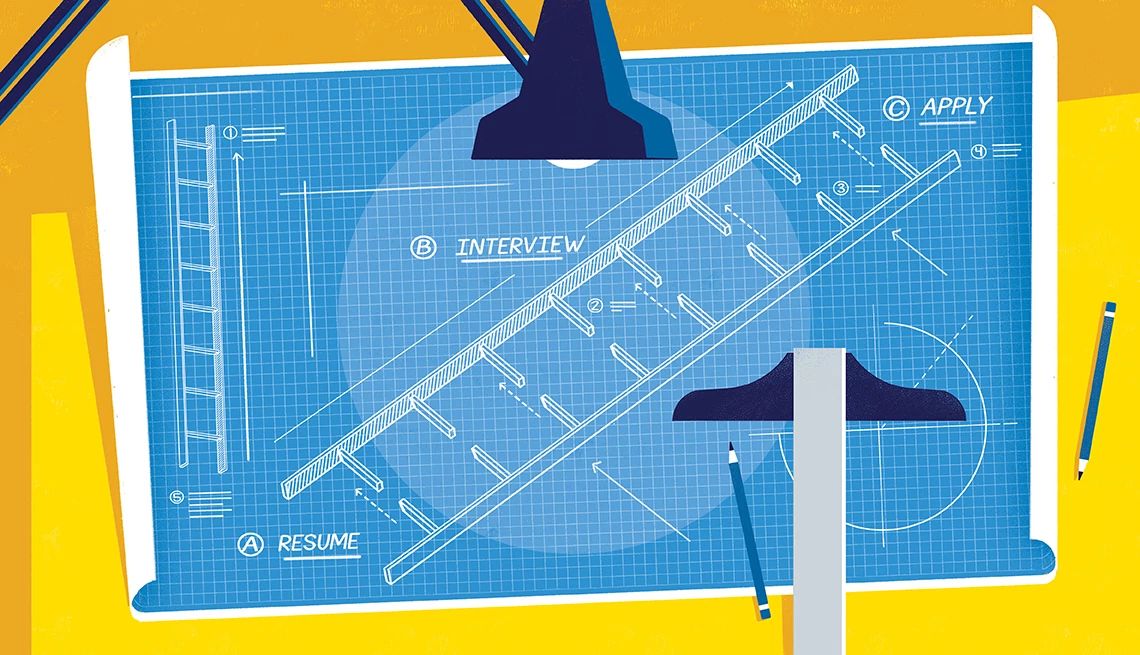

Trabajar con un terapeuta digital no significa necesariamente contarles todo a las innovadoras inteligencias artificiales que dominan los titulares noticiosos. Bard, de Google, el nuevo Microsoft Bing y, en particular, ChatGPT de Open AI, cuyo lanzamiento el otoño pasado generó un tsunami de interés en todo lo que tenga que ver con la inteligencia artificial, son lo que se llaman “IA generativas”.

Han sido entrenadas con inmensas cantidades de datos generados por humanos y pueden crear nuevo material basándose en la información que se les ha ingresado, pero no cuentan necesariamente con respaldo clínico. Mientras que ChatGPT y otras herramientas similares pueden ayudar a planificar la boda de tu hijo, escribir cartas de queja o generar código informático, usar sus datos para crear tu psiquiatra o psicoterapeuta personal tal vez no sea uno de sus puntos fuertes, al menos por ahora.

Nicholas C. Jacobson, profesor adjunto de Ciencias de Datos Biomédicos y Psiquiatría en Dartmouth, en Lebanon, Nuevo Hampshire, ha estado explorando los bots de inteligencia artificial generativa, así como aquellos que utilizan un guion predefinido (basados en reglas), por aproximadamente tres años y medio. Él ve beneficios y peligros potenciales en ambos.

"Esencialmente, lo que hemos encontrado con los trabajos creados a partir de guiones predefinidos es que son algo torpes”, dice. Por otro lado, “es mucho más improbable que se equivoquen. ...Y pueden permitir el acceso a intervenciones que muchas personas no podrían obtener de otra manera, particularmente en un plazo de tiempo breve”.

Jacobson dice que está “muy entusiasmado y muy asustado” por lo que las personas quieren hacer con la inteligencia artificial generativa, especialmente con los bots que probablemente se introduzcan pronto en el mercado. Esa misma opinión se vio reflejada el martes, cuando más de 350 ejecutivos, investigadores e ingenieros que trabajan en IA publicaron una declaración del Center for AI Safety, una organización sin fines de lucro, en la que advierten sobre los riesgos (en inglés) de la tecnología.

Los bots de IA generativa pueden brindar consejos útiles a alguien que necesita ayuda inmediata. Pero como estos bots pueden confundirse fácilmente, también pueden ofrecer información engañosa, sesgada y peligrosa, o consejos que parecen creíbles, pero son erróneos. Eso podría empeorar los problemas de salud mental en personas vulnerables.

Se requiere ‘supervisión rigurosa’

“La única manera en que esta área debería avanzar —y me temo que probablemente no avance de esta manera— es con cautela”, dice Jacobson.

La indicación de la Organización Mundial de la Salud es la “supervisión rigurosa” de las tecnologías de salud basadas en inteligencia artificial, según una declaración que la agencia de las Naciones Unidas emitió a mediados de mayo.

.jpg?crop=true&anchor=13,195&q=80&color=ffffffff&u=lywnjt&w=2008&h=1154)

También te puede interesar

6 innovaciones para que las personas puedan vivir mejor a medida que envejecen

La seguridad y la independencia son posibles gracias a la tecnología.

¿Qué es ChatGPT y cómo usarlo?

Los conceptos básicos sobre esta herramienta de la inteligencia artificial.

La inteligencia artificial contribuye a la salud de los veteranos

6 formas en que la inteligencia artificial se aplica para el cuidado de la salud.